Word Mover's Distance: word2vecの文書間距離への応用

word2vecによって得られる語の分散表現を用いて文書間の距離(非類似度)を計算する手法についての論文を読みました。 せっかくなので解説してみます。

TL;DR

この論文では Word Mover’s Distance(WMD) という文書間距離の計算手法を提案しています。 提案手法は手っ取り早く言うと次のようなものです。

- 文書A, B間の距離 =

A, Bの語同士を対応付けることでAをBに変換するとき、

対応付けのコストが最も低い場合のコストの総和 - 語xを語yに対応付けるコスト =

x, yの分散表現ベクトルの距離

例えば次の文書 と

または

との距離を考えてみます。

ストップワードを除いた上で、各文書の意味の似ている語同士を対応付けます。 さらに各対応付けのコストを語同士の分散表現の距離として算出し、その総和を求めます。

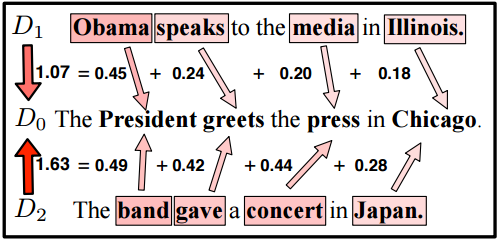

下の図は語の対応付けとそのコストを矢印とそれに付与された値で示しています。

(Figure 2. (Top) from [1])

このコストの総和を文書間の距離と考える、というのがWMDのアイデアとなります。

図では に対する距離が

のほうが

よりも小さくなっています。

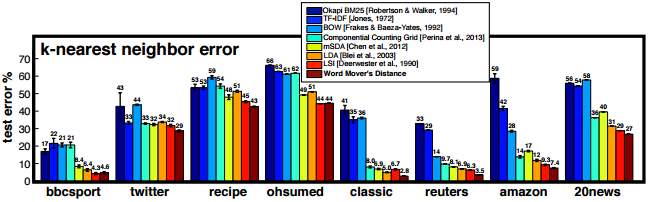

論文では文書の近傍を求めるタスクにおいて、多くのデータセットで提案手法により良好な結果が得られたとしています。

(Figure 3. from [1])

特に twitter のような語数の比較的短い文書からなるデータセットでは、従来手法より良好な結果を残しているようです。

以下では主にWMDの計算アルゴリズムについて、もう少し詳しく解説していきます。

従来の文書類似度計算における課題

単純な文書類似度としては Bag-of-Words (BoW) 表現のコサイン値がよく用いられます。 しかし文書同士の共通語が少ない場合、BoWでは文書間の意味的な類似度を測ることが困難です。

例えば上記の 文書 ,

の単純なBoW表現は次のようになりますが、これらは共通語を持たないためベクトル同士のコサイン値はゼロとなります。

従来ではLSIやLDAなどの次元削減手法を利用してこの問題に対処することが試みられていましたが、精度面でそれほど大きな改善を実現するには至っていませんでした。

最近ではニューラルネットの発達に伴い、文書自体の分散表現を計算する手法も提案されています。 これらの手法は高い精度を実現できると主張されていますが、NN特有のハイパーパラメータチューニングが必要となる場合もあります。

WMDの考え方

WMDは上記の問題を別のアプローチで解決しようとしています。

上記のとおり文書 ,

には共通語こそありませんが、人間の目には media と press のようなそれぞれの語同士は非常に近い意味をもつように見えます。

word2vec を用いれば、このような語の意味類似度を捉えた分散表現ベクトルが得られます。

WMDではこの性質を利用して文書間の距離を求めます。 その考え方は大雑把に言えば、 文書Aの語を類似する(=分散表現間の距離が小さい)語で置き換えて文書Bに変換できるならば、文書A, Bの類似度は大きい(=距離が小さい) というようなものです。

このような考え方に基づいて、WMDでは文書A,B間の距離を、A,Bの語同士を対応付けて文書Aを文書Bに変換するのにかかる「コスト」として計算します。

語の対応付けのコスト

まずある語を別の語に対応付ける場合のコストについて考えます。 意味の似ている語同士の対応付けはコストが低い、という特性を満たすよう、語同士の分散表現のL2距離をコストとします。

すなわち、語 を語

に対応付けるコスト

を次のように定義します。

文書の変換コスト

次に、語の対応付けに基づく置き換えにより、ある文書を別の文書に変換することを考えてみます。 この置き換えにおいては文書中の意味語(ストップワード以外の語)のみに注目し、語順などは考慮しないものとします。

先程の を

に変換する場合、各語を次のように対応付ければよさそうです。

この変換のコストは、単純に考えれば各対応付けのコストの総和とするのが良さそうです。

イメージとしては、この総和が小さいほど文書は意味的に類似すると言えそうです。

問題の一般化

これまでの例では意味語の数が同じで、各語も意味的にほぼ1対1に対応づけることができました。 しかし次のような文書同士では、単純に語を置換することでは文書を変換できません。

任意の2文書間の距離を一貫した基準のもとで計算するには、単純な置き換えによる変換ではなくより一般化された方法を考える必要があります。

そこでまず文書の特徴表現として語の頻度分布を用います。

例えば ,

の特徴ベクトルは次のようになります。

ここでベクトルの各成分は、文書中の語の正規化された出現頻度(TF)となっています。

さらに各語に対応する成分を変換先の文書の複数の語に分配することで、語の頻度分布全体を変換先の分布に移すことを考えます。

この変換を次のような行列 で表します。

例えばこの行列の7行目は、 における語 speak の重み1/3のうち、それぞれ1/4と1/12をそれぞれ

の語 greets と press に移すことを表します。

この対応付全体のコストは、それぞれの語同士の対応コストに分配量に応じた重みかけた値の総和として計算できます。

ここで、上の行列はあくまで考えられる変換のひとつでしかありません。 WMDではそのような変換の中でコストの総和が最小となるものを求め、このコストの総和が文書間の距離とします。

最適化問題としての定式化と解法

上記の内容を最適化問題として定式化すると次のようになります。

行列 の各行ベクトルは、元の文書中の各語に対応します。

その各成分は、元の文書の語分布におけるその語の成分を、変換先の文書の各語にどのように分配するかを表します。

よって行の成分の総和は、元の文書の語分布における各語の成分と一致します。

同様に行列の各列ベクトルの成分の総和は、変換先の文書の語分布に各語の成分と一致します。

コストが最小となる変換のコストを文書間の距離とするので、上式を制約条件とする次の最適化問題を解くことができれば文書間の距離が求まります。

実は上の最適化問題は Earth Mover Distance (EMD) と呼ばれる最適化問題の特殊な形式になっています。 EMDを求めるアルゴリズムは既に知られているので、それを用いればWMDを計算できます。

この記事ではEMDについて詳しく解説することはしませんが、以下の記事が詳しいですので興味のある方はご参照ください。

WMDの長所と短所

WMDの長所としては次のような点が挙げられます。

- 精度が高い

- 直感的にわかりやすい

- ハイパーパラメータが存在しないためチューニングが不要

逆に短所としては次のような点が挙げられます。

- 計算量が大きい(類似度計算1回で語数

に対して [tex: O(p3 \log p)] )

このような性質から、単なるBoWの類似度では望ましい精度が得られず、かつ計算量が多くても許容できるようなケースでWMDが有効であると考えられます。

なお、ある文書に対する近傍文書を上位k件まで取得できればよいようなケース(文書検索など)では、WMDよりも計算量の小さい下界を利用し、計算量を大幅に抑えることができます。 今回はその詳細については割愛しますが、論文には精度の変動の評価も含めて詳しく書かれているので、知りたい方は論文を読まれることをお薦めします。

まとめ

語の分散表現を文書類似度や文書特徴量に応用する手法は多いですが、ハイパーパラメータチューニングなしに高い精度を実現できるWMDは特に魅力的に写ります。 また最近ではWMDを教師あり学習に拡張した論文なども出ているようです。

機会があれば実問題で試してみたいものです。

追記

2017/04/05

gensimを使うと学習済みモデルを用いて簡単にWMDを計算できるようです。